本教程将介绍如何使用ChatGPT,并提供一些实用的技巧和注意事项,帮助每一个人更好地利用ChatGPT解决问题。

到此您如果看明白了点击这里直接返回

ChatGPT是一款基于GPT3.5或GPT-4模型的AI聊天助手,它能够理解和生成自然语言,为用户提供帮助。因此,学会合理的组织提问语言和调节模型参数,可以让你在节约成本的同时获得你最想要的回答。在本教程中,我将介绍如何用更专业的方式使用ChatGPT。

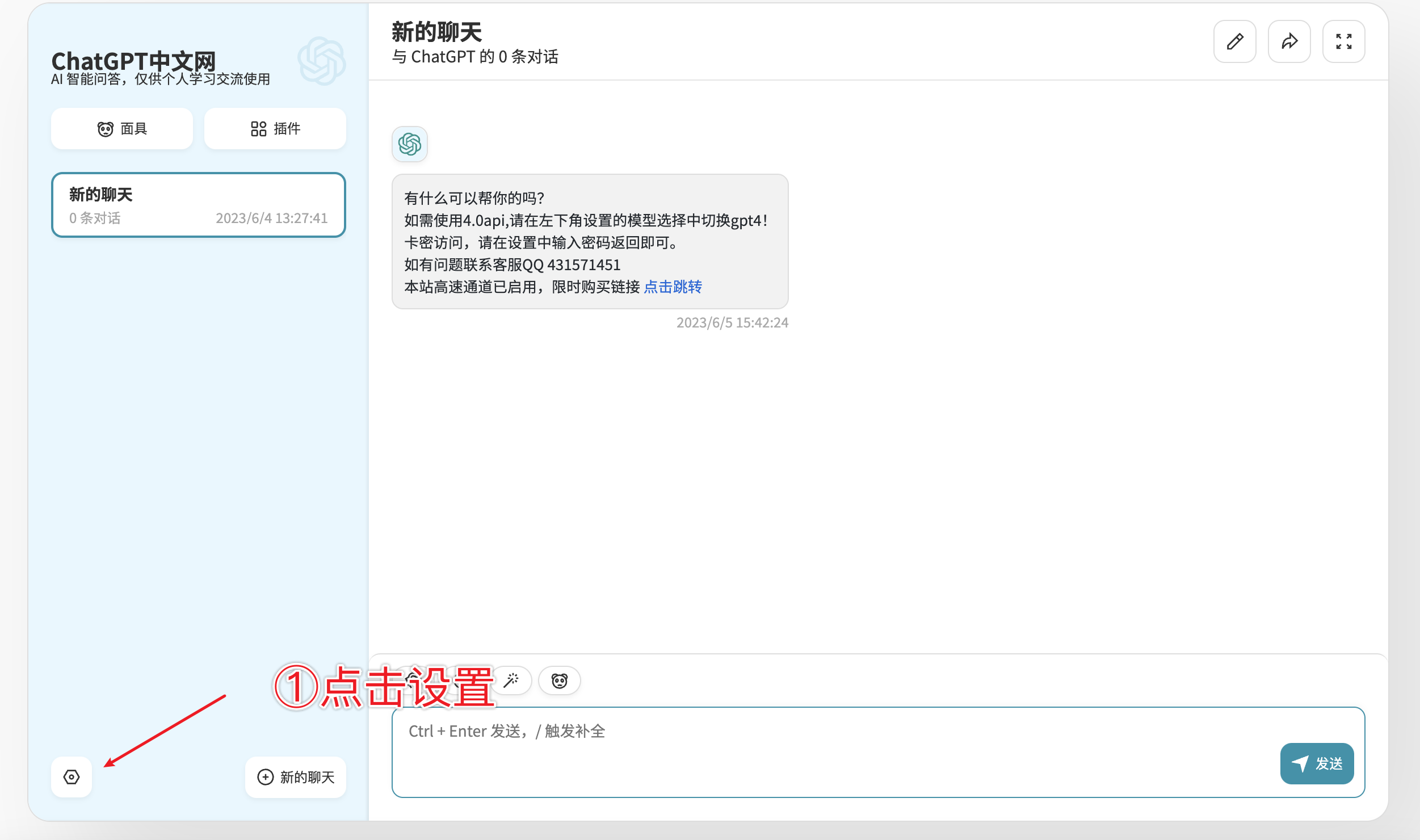

由于特殊原因,国内无法访问ChatGPT官网,我使用OpenAI提供的API部署了一个聊天网站,可以通过注册试用。目前可用的模型有

gpt-3.5-turbo和gpt-4。

组织提问语言

首先,ChatGPT只是一个模型,它并没有感情,它只是一个庞大的,使用自然语言作为查询接口的知识数据库。因此,它的回答质量很大一部分取决于你的提问质量。如果你的提问语言不够清晰,ChatGPT就无法理解你的意思,也就无法给出你想要的回答。因此,我们需要学会如何组织提问语言,这其实本身是一项高级的个人能力,没有那么容易学会。但是没有关系,平台提供了许多优秀的预设对话,可以帮助你特化ChatGPT的能力,详情查看使用面具。

调节模型参数

这是API版本特有的功能,如果大家曾经了解过官网的版本,那么你会发现官网是没有提供这部分功能的。 截至目前,GPT4仍然是世界上最强大的模型,在此基础上,API版本比官网更加强大,因为它可以支持最大长度为8192的上下文,而官网的GPT4和GPT3.5一样只支持最大长度为4096的上下文。这意味着,API版本的GPT4可以记住更长的对话,因此可以做出更令人满意的回答。

在API版本中,我们可以通过调节模型参数来影响它的回答。这里介绍最好用的几个参数:

-

max_tokens:1~n 允许生成的最大长度,最大值取决于使用的模型支持的最大上下文长度,gpt3.5-turbo最大支持4096,gpt-4目前可用版本最大支持8192。 -

temperature:0~1 温度,控制模型生成的多样性。值越大,生成的回答越随机,越多样化,但是会导致回答越不准确,反之,回答越准确,但是会导致回答越单一。 -

presence_penalty:-2.0~2.0 控制话题新鲜度,值越小,已出现过的词会被重复使用,反之,出现过的词在之后很难重复出现。

前/后处理参数

为了让大家有舒适的聊天体验,网站本身也会对发送的消息和获取的回答进行一些处理,这些处理参数可以通过设置来调节:

-

附带历史消息数:每次请求携带的历史消息数,能够确保ChatGPT以已有的一定量的聊天记录的内容为基础进行回答。如果设置得太短,它比较健忘,之前几条消息里说过的概念它已经忘记了,设置太长,容易超过模型上下文限制,然后触发下面的历史消息压缩功能。

请注意,token的计费是包括了历史消息的,因此,如果你设置了太长的附带历史消息,那么你的token会被消耗得很快。请自己实验,找到一个自己能接受的值。

-

历史消息长度压缩阈值:当历史消息长度超过这个阈值时,会对历史消息进行压缩,(后台自动使用gpt-3.5进行内容摘要),这样可以保证ChatGPT能够一直回答问题,即使上下文已经超过了模型的最大长度。

可以结合上一条参数来设置,例如,如果你设置了附带历史消息数为5,同时设置压缩阈值为1000,这样,当你这5条聊天记录字数超过1000时,ChatGPT就会自动压缩历史消息,缩短为一条精简的聊天记录,这样就可以保证ChatGPT一直能够回答问题,还能有不错的记忆功能。